Fallstudien zum Bedeutungswandel: Automatische Disambiguierung und Visualisierung disambiguierter lexikalischer Einheiten: Unterschied zwischen den Versionen

Bartz (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „...“) |

|||

| Zeile 1: | Zeile 1: | ||

| − | ... | + | [[Kategorie:Fallstudien]] |

| + | |||

| + | == 1 Entwicklung und Ausdifferenzierung von Bedeutungen: KobRA-Anwendungsbereich Lexikographie == | ||

| + | |||

| + | Die Entwicklung und Ausdifferenzierung von Bedeutungen ist für Linguisten in zweierlei Hinsicht interessant: Lexikographen verfolgen Wortentwicklungen, um adäquate lexikographische Beschreibungen erstellen bzw. vorhandene Wörterbucheinträge aktualisieren zu können (Storrer, 2011). Forscher im Bereich der Historischen Semantik fragen nach den Möglichkeiten, Bedingungen und Folgen semantischer Innovationen (Fritz, 2012; Fritz 2005; Keller & Kirschbaum 2003). Für den Erkenntnisgewinn entscheidend ist in beiden Fällen die Verfügbarkeit strukturierter Textkorpora, die es erlauben, die Verwendung eines Wortes über größere Zeiträume hinweg nachzuvollziehen. Während insbesondere im Rahmen von CLARIN umfangreiche synchrone und diachrone Textkorpora mit Metadaten zu Erscheinungsdatum und Textsorte sowie komfortable Abfrage- und Analysewerkzeuge zur Verfügung stehen, ist die großflächige automatische semantische Annotation der Korpora nach gegenwärtigem Stand der Technik noch nicht zufriedenstellend möglich (Rayson & Stevenson, 2008). Bei der Korpus-basierten Untersuchung von Bedeutungswandel müssen deshalb bislang die zu einem Wort gefundenen Einzelbelege manuell disambiguiert werden. Verbreitung und Prozesse des Bedeutungswandels können daher aktuell lediglich anhand weniger Beispiele und auf einer vergleichsweise geringen Datenbasis beschrieben werden (Fritz 2005; Keller & Kirschbaum 2003). Ziel der im Folgenden beschriebenen Fallstudie ist es, Data-Mining-Verfahren zu erproben, die den Korpus-Nutzer dadurch unterstützen, dass sie eine Menge von Snippets zu einem lexikographisch interessanten Wort nach den Bedeutungen dieses Wortes partitionieren, sodass die Snippets für einzelne Bedeutungen auch einzeln zählbar sind (Details s. Bartz et al. im Erscheinen). | ||

| + | |||

| + | == 2 Bezug zu den Aufgabenstellungen des KobRA-Projekts: Disambiguieren/Visualisieren == | ||

| + | |||

| + | Das übergreifende Ziel des KobRA-Projekts besteht darin, durch den Einsatz innovativer Data-Mining-Verfahren (insbesondere Verfahren des maschinellen Lernens) die Möglichkeiten der empirischen linguistischen Arbeit mit strukturierten Sprachressourcen zu verbessern. Die auf dieser Seite dokumentierte Fallstudie bearbeitet einen Problemtyp, der in vielen korpusbasierten linguistischen Untersuchungen auftritt: | ||

| + | |||

| + | Ein Wort, dessen Gebrauch untersucht werden soll, tritt im Korpus mit hoher Frequenz auf. Die bei der Korpussuche generierten Trefferlisten sind aber nicht unmittelbar nutzbar, weil das gesuchte Wort in verschiedenen Bedeutungen vorkommt, die im Rahmen der Untersuchung zu unterscheiden und ggf. einzeln zu zählen sind, was aber mit der vorhandenen Korpustechnologie nicht automatisch möglich ist. Benötigt werden deshalb Data-Mining-Verfahren, die den Korpus-Nutzer dabei unterstützen, Trefferlisten zu einem Wort nach verschiedenen Bedeutungen dieses Wortes zu partitionieren. | ||

| + | |||

| + | Die Partitionierung ermöglicht zugleich anspruchsvolle Visualisierungen, die den Gebrauch von Wörtern über Zeitspannen und Textsortenbereiche hinweg in seiner Entwicklung auch grafisch sichtbar machen sowie neue Fragestellungen und Hypothesen induzieren können. Ein Werkzeug zur Visualisierung disambiguierter lexikalischer Einheiten wird daher ergänzend erprobt. | ||

| + | |||

| + | == 3 Data-Mining-Verfahren und -Umgebung, Werkzeuge zur Annotation und Visualisierung == | ||

| + | |||

| + | === 3.1 Einlesen, Repräsentation und Nutzung der Korpusdaten === | ||

| + | |||

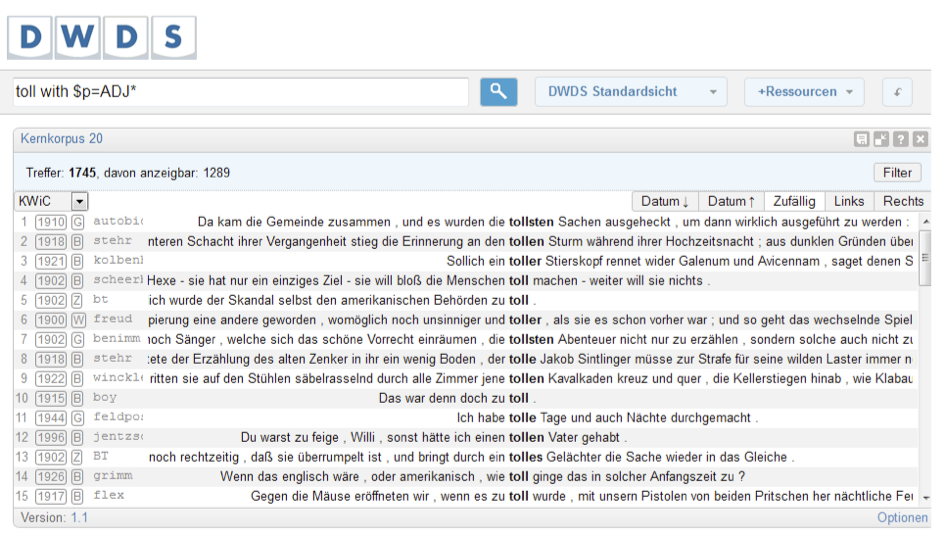

| + | Die Data-Mining-Verfahren des KobRA-Projekts setzen direkt an der von einem Korpusabfragesystem zu einem gesuchten Ausdruck ausgegebenen Keyword-in-Context-Ergebnisliste (KwiC-Liste) an (s. Abbildung 1). Diese besteht aus kurzen Text-Snippets für jeden Treffer der Abfrage, die das Suchwort in einem Kontext von einigen Sätzen erhalten (je nach Fragestellung und genutztem Korpus variabel, meist 1-3 Sätze). Grundlage für das maschinelle Lernen sind also nicht die vollständigen Korpora, sondern eine vom Korpus-Nutzer auf Grundlage seiner Expertise schon auf die hochrelevanten Daten konzentrierte Auswahl. Die gängigen Abfragesysteme bieten dazu heute über ausgefeilte Abfragesprachen bereits umfangreiche Möglichkeiten an, das Suchergebnis abhängig von bestimmten Merkmalen möglichst präzise einzuschränken. Zu diesen Merkmalen zählen Wortformen und Phrasen, Wortabstände und -fenster bis hin zu regulären Ausdrücken für die Mustersuche, Lemmata (Rückführung der flektierten Wortformen auf die Grundform), morphosyntaktischen (Wortarten) und syntaktischen Informationen. | ||

| + | |||

| + | [[Datei:Abbildung 1 Abfrage zum Suchwort "toll" im DWDS-Kernkorpus des 20 Jh über das Abfragesystem des DWDS mit Nutzung des Wortarten-Filters (vgl Geyken 2007, Klein & Geyken 2010).png|mini|1000px|links|Abbildung 1: Abfrage zum Suchwort „toll" im DWDS-Kernkorpus des 20. Jh. über das Abfragesystem des DWDS mit Nutzung des Wortarten-Filters (vgl. Geyken 2007, Klein & Geyken 2010)]] | ||

| + | |||

| + | Die durch Korpusabfrage gewonnenen Daten können unabhängig vom verwendeten Korpus in die im Projekt genutzte und angepasste Data-Mining-Umgebung (s. 2.4) eingelesen werden. Einzige Voraussetzung ist die Formatierung in einem Tabellenformat (z.B. als Komma-separated-Values/CSV oder XLS). Alternativ steht mit dem im Projekt entwickelten Plug-in ein Werkzeug („LinguisticQuery-Operator“) zur Verfügung, das die Abfrage der durch die KobRA-Projektpartner bereitgestellten Ressourcen direkt aus der Data-Mining-Umgebung heraus ermöglicht. Das Werkzeug unterstützt auch die oben genannten erweiterten Abfragemöglichkeiten gängiger Korpusabfragesysteme. Für das Auslesen der in vielen Korpora genutzten XML-Datenbasis (nach TEI-Standard, z.B.: Beißwenger et al. 2012) wurde als Bestandteil des RapidMiner-Plug-ins außerdem ein TEI-Reader bereitgestellt. | ||

| + | |||

| + | Die KwiC-Snippets werden für das maschinelle Lernen als Sequenzen von Wörtern repräsentiert (‚Bags-of-Words‘; grundlegende Repräsentation). Jedes Snippet wird als großer Vektor mit Einträgen für jedes Wort der Gesamtmenge aller Wörter in einer KwiC-Liste dargestellt (ein sogenannter ‚Wortvektor‘). In einer KwiC-Liste mit N Wörtern ist der Vektor N-dimensional. Die Elemente der Wortvektoren können binär sein und das bloße Vorkommen eines Wortes in einem Snippet oder Häufigkeiten des Wortes in einem Snippet und in allen Snippets der KwiC-Liste darstellen. Formal ist ein Wortvektor v für einen endlichen Text definiert als ein N-dimensionaler Vektor, d.h. alle möglichen Texte enthalten N unterschiedliche Wörter. Für v gilt, dass die i-te Komponente die Anzahl der Vorkommen oder (normalisierte) Frequenz von Wort i im Text ist. Ordnet man diese Wörter, so kann man jedes Wort über einen Index i identifizieren. Damit definieren wir eine Abbildung Phi, die die Snippets (hier wie ‚Texte‘ behandelt) als Wortvektoren abbildet. Dies geschieht formal so: | ||

Version vom 22. Juli 2015, 10:27 Uhr

Inhaltsverzeichnis

1 Entwicklung und Ausdifferenzierung von Bedeutungen: KobRA-Anwendungsbereich Lexikographie

Die Entwicklung und Ausdifferenzierung von Bedeutungen ist für Linguisten in zweierlei Hinsicht interessant: Lexikographen verfolgen Wortentwicklungen, um adäquate lexikographische Beschreibungen erstellen bzw. vorhandene Wörterbucheinträge aktualisieren zu können (Storrer, 2011). Forscher im Bereich der Historischen Semantik fragen nach den Möglichkeiten, Bedingungen und Folgen semantischer Innovationen (Fritz, 2012; Fritz 2005; Keller & Kirschbaum 2003). Für den Erkenntnisgewinn entscheidend ist in beiden Fällen die Verfügbarkeit strukturierter Textkorpora, die es erlauben, die Verwendung eines Wortes über größere Zeiträume hinweg nachzuvollziehen. Während insbesondere im Rahmen von CLARIN umfangreiche synchrone und diachrone Textkorpora mit Metadaten zu Erscheinungsdatum und Textsorte sowie komfortable Abfrage- und Analysewerkzeuge zur Verfügung stehen, ist die großflächige automatische semantische Annotation der Korpora nach gegenwärtigem Stand der Technik noch nicht zufriedenstellend möglich (Rayson & Stevenson, 2008). Bei der Korpus-basierten Untersuchung von Bedeutungswandel müssen deshalb bislang die zu einem Wort gefundenen Einzelbelege manuell disambiguiert werden. Verbreitung und Prozesse des Bedeutungswandels können daher aktuell lediglich anhand weniger Beispiele und auf einer vergleichsweise geringen Datenbasis beschrieben werden (Fritz 2005; Keller & Kirschbaum 2003). Ziel der im Folgenden beschriebenen Fallstudie ist es, Data-Mining-Verfahren zu erproben, die den Korpus-Nutzer dadurch unterstützen, dass sie eine Menge von Snippets zu einem lexikographisch interessanten Wort nach den Bedeutungen dieses Wortes partitionieren, sodass die Snippets für einzelne Bedeutungen auch einzeln zählbar sind (Details s. Bartz et al. im Erscheinen).

2 Bezug zu den Aufgabenstellungen des KobRA-Projekts: Disambiguieren/Visualisieren

Das übergreifende Ziel des KobRA-Projekts besteht darin, durch den Einsatz innovativer Data-Mining-Verfahren (insbesondere Verfahren des maschinellen Lernens) die Möglichkeiten der empirischen linguistischen Arbeit mit strukturierten Sprachressourcen zu verbessern. Die auf dieser Seite dokumentierte Fallstudie bearbeitet einen Problemtyp, der in vielen korpusbasierten linguistischen Untersuchungen auftritt:

Ein Wort, dessen Gebrauch untersucht werden soll, tritt im Korpus mit hoher Frequenz auf. Die bei der Korpussuche generierten Trefferlisten sind aber nicht unmittelbar nutzbar, weil das gesuchte Wort in verschiedenen Bedeutungen vorkommt, die im Rahmen der Untersuchung zu unterscheiden und ggf. einzeln zu zählen sind, was aber mit der vorhandenen Korpustechnologie nicht automatisch möglich ist. Benötigt werden deshalb Data-Mining-Verfahren, die den Korpus-Nutzer dabei unterstützen, Trefferlisten zu einem Wort nach verschiedenen Bedeutungen dieses Wortes zu partitionieren.

Die Partitionierung ermöglicht zugleich anspruchsvolle Visualisierungen, die den Gebrauch von Wörtern über Zeitspannen und Textsortenbereiche hinweg in seiner Entwicklung auch grafisch sichtbar machen sowie neue Fragestellungen und Hypothesen induzieren können. Ein Werkzeug zur Visualisierung disambiguierter lexikalischer Einheiten wird daher ergänzend erprobt.

3 Data-Mining-Verfahren und -Umgebung, Werkzeuge zur Annotation und Visualisierung

3.1 Einlesen, Repräsentation und Nutzung der Korpusdaten

Die Data-Mining-Verfahren des KobRA-Projekts setzen direkt an der von einem Korpusabfragesystem zu einem gesuchten Ausdruck ausgegebenen Keyword-in-Context-Ergebnisliste (KwiC-Liste) an (s. Abbildung 1). Diese besteht aus kurzen Text-Snippets für jeden Treffer der Abfrage, die das Suchwort in einem Kontext von einigen Sätzen erhalten (je nach Fragestellung und genutztem Korpus variabel, meist 1-3 Sätze). Grundlage für das maschinelle Lernen sind also nicht die vollständigen Korpora, sondern eine vom Korpus-Nutzer auf Grundlage seiner Expertise schon auf die hochrelevanten Daten konzentrierte Auswahl. Die gängigen Abfragesysteme bieten dazu heute über ausgefeilte Abfragesprachen bereits umfangreiche Möglichkeiten an, das Suchergebnis abhängig von bestimmten Merkmalen möglichst präzise einzuschränken. Zu diesen Merkmalen zählen Wortformen und Phrasen, Wortabstände und -fenster bis hin zu regulären Ausdrücken für die Mustersuche, Lemmata (Rückführung der flektierten Wortformen auf die Grundform), morphosyntaktischen (Wortarten) und syntaktischen Informationen.

Die durch Korpusabfrage gewonnenen Daten können unabhängig vom verwendeten Korpus in die im Projekt genutzte und angepasste Data-Mining-Umgebung (s. 2.4) eingelesen werden. Einzige Voraussetzung ist die Formatierung in einem Tabellenformat (z.B. als Komma-separated-Values/CSV oder XLS). Alternativ steht mit dem im Projekt entwickelten Plug-in ein Werkzeug („LinguisticQuery-Operator“) zur Verfügung, das die Abfrage der durch die KobRA-Projektpartner bereitgestellten Ressourcen direkt aus der Data-Mining-Umgebung heraus ermöglicht. Das Werkzeug unterstützt auch die oben genannten erweiterten Abfragemöglichkeiten gängiger Korpusabfragesysteme. Für das Auslesen der in vielen Korpora genutzten XML-Datenbasis (nach TEI-Standard, z.B.: Beißwenger et al. 2012) wurde als Bestandteil des RapidMiner-Plug-ins außerdem ein TEI-Reader bereitgestellt.

Die KwiC-Snippets werden für das maschinelle Lernen als Sequenzen von Wörtern repräsentiert (‚Bags-of-Words‘; grundlegende Repräsentation). Jedes Snippet wird als großer Vektor mit Einträgen für jedes Wort der Gesamtmenge aller Wörter in einer KwiC-Liste dargestellt (ein sogenannter ‚Wortvektor‘). In einer KwiC-Liste mit N Wörtern ist der Vektor N-dimensional. Die Elemente der Wortvektoren können binär sein und das bloße Vorkommen eines Wortes in einem Snippet oder Häufigkeiten des Wortes in einem Snippet und in allen Snippets der KwiC-Liste darstellen. Formal ist ein Wortvektor v für einen endlichen Text definiert als ein N-dimensionaler Vektor, d.h. alle möglichen Texte enthalten N unterschiedliche Wörter. Für v gilt, dass die i-te Komponente die Anzahl der Vorkommen oder (normalisierte) Frequenz von Wort i im Text ist. Ordnet man diese Wörter, so kann man jedes Wort über einen Index i identifizieren. Damit definieren wir eine Abbildung Phi, die die Snippets (hier wie ‚Texte‘ behandelt) als Wortvektoren abbildet. Dies geschieht formal so: